Microsoft lanzó Phi-3 a principios de esta semana en HuggingFace, Ollama y el catálogo Azure AI. Aunque no alcanza las capacidades de conocimiento general de Copiloto de Windowsla tecnología de IA de código abierto representa la cuarta generación de pequeños modelos lingüísticos de Redmond que rivalizan con los principales LLM en velocidad, eficacia y rendimiento.

Con 3.800 millones de parámetros, Phi-3 es ligeramente mayor que su predecesor pero sigue siendo lo suficientemente pequeño como para funcionar en tan sólo 1,8 GB de almacenamiento móvil. A modo de comparación, un LLM complejo típico como Llama o GPT-3.5 utiliza cientos de miles de millones de parámetros para comprender la entrada y resulta poco práctico almacenarlo de forma nativa. GPT-5, que se lanzará este veranose espera que tenga un tamaño de billones de parámetros. Según las leyes de escalado convencionales, más parámetros significan resultados más inteligentes. Pero, según Microsoft, éste podría no ser necesariamente el caso.

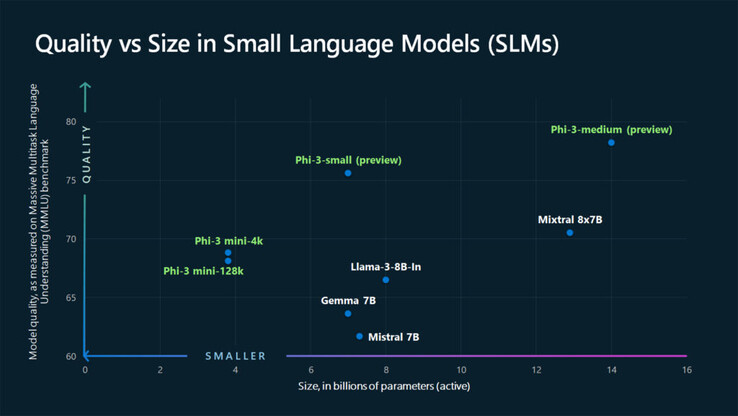

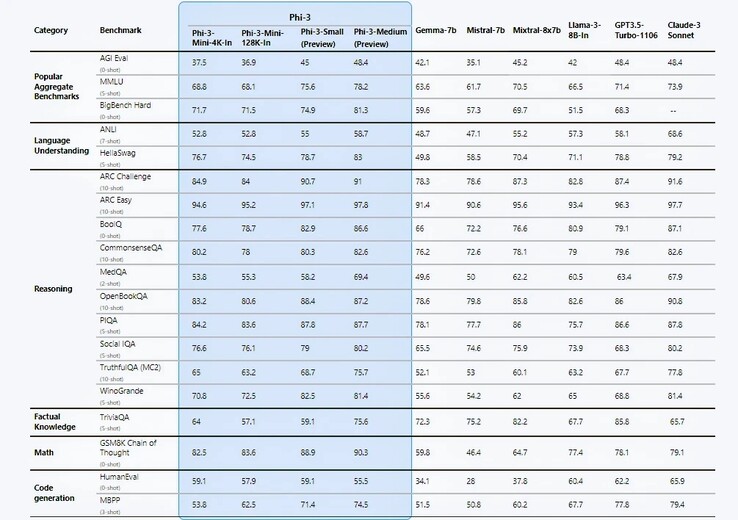

Microsoft hace algunas afirmaciones atrevidas en su informe técnico https://arxiv.org/pdf/2404.14219; la principal de ellas son los puntos de referencia de rendimiento que son, según admite la propia empresa, puramente académicos. En 12 de las 19 pruebas de referencia, Phi-3-mini parece superar a Llama-3-instruct a pesar de funcionar con más del doble de parámetros. Con el Phi-3-pequeño de 7B y el Phi-3-mediano de 14B, los resultados fueron aún más asombrosos.

Los ingenieros atribuyen estas ganancias de eficiencia a su conjunto de datos de entrenamiento cuidadosamente curado derivada de dos fuentes: contenido web de "calidad de libro de texto" y datos generados por IA diseñados para enseñar lenguaje, conocimientos generales y razonamiento de sentido común con una lista seleccionada de 3000 palabras que sirven como bloques de construcción. Los investigadores de Microsoft afirman que este tipo de receta de datos permitió al Phi-2 del año pasado igualar el rendimiento del modelo de Meta, considerablemente mayor (70 B) Modelo Llama-2.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck

Eric Boyd, vicepresidente corporativo de Azure AI, presume a través de The Verge de que Phi-3 es tan capaz como GPT-3.5, aunque en un "factor de forma más pequeño". Sin embargo, Phi-3 sigue adoleciendo de una deficiencia en el conocimiento de los hechos debido a su tamaño limitado. ¿Quizás se trate de una compensación necesaria para que la IA funcione de forma nativa en lugar de a través de la computación en nube?

Teniendo en cuenta que la flexibilidad y la rentabilidad son cuestiones clave para las empresas, no es de extrañar que éstas ya hayan empezado a aprovechar las capacidades de las MST. Sin embargo, Phi-3 tiene una dura competencia. La Llama-3 de Meta https://llama.meta.com/llama3/, Claude-3 de Anthropic, Google Gemini y Gemma tienen todos versiones ligeras capaces de soportar la computación de borde en móviles. Y aunque Phi-3 parece competir favorablemente, Gemini Nano ya ha llegado a dispositivos como el Google Pixel 8 Pro y la serie Samsung Galaxy S24(784 $ en Amazon).

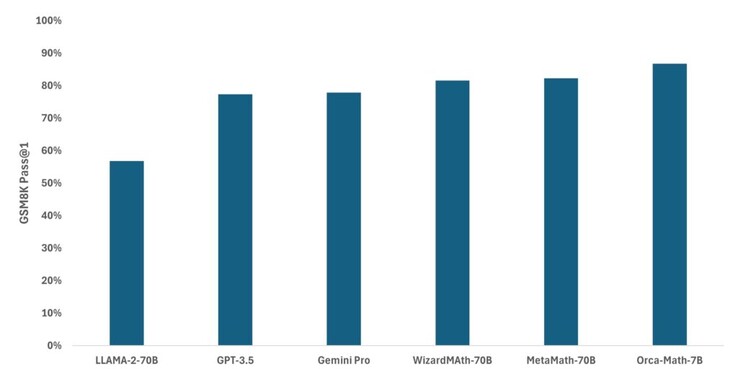

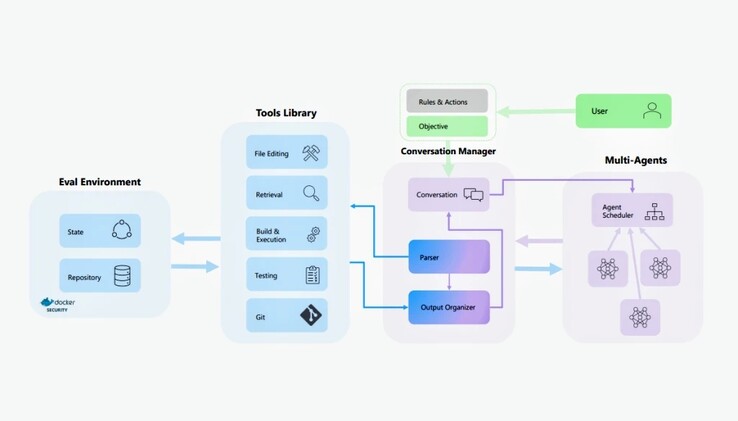

La familia Phi-3 de modelos de IA no es, ni mucho menos, la única SLM en la que Microsoft ha estado trabajando. El mes pasado, la empresa adaptó Mistral para crear Orca-Mathun modelo especializado que demostró ser considerablemente más preciso que Llama, GPT-3.5 y Gemini Pro en matemáticas de primaria. AutoDev, un proyecto más reciente, se basa en AutoGen y Auto-GPT para planificar y ejecutar de forma autónoma tareas de programación basadas en objetivos definidos por el usuario. Las guerras de la IA están lejos de haber terminado, pero al menos en la escala inferior, tenemos un contendiente líder.

![Microsoft quiere saber si se plantearía adquirir un nuevo dispositivo portátil para juegos en los próximos cinco años (Fuente de la imagen: Logitech [editado])](fileadmin/_processed_/a/0/csm_Logitech-G-Cloud_f62f43f9e7.jpg)