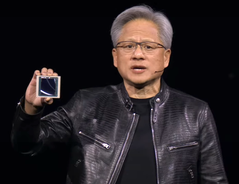

Huang, CEO de Nvidia, desvela los últimos productos de IA para la empresa junto con los avances en capacidades de vehículos autónomos y robots humanoides durante la keynote de la GTC 2024

Nvidia El consejero delegado Jensen Huang ha revelado los últimos productos y servicios de IA de la compañía durante la keynote en GTC 2024 el 18 de marzo de 2024 en San José, California. Dirigidas a clientes empresariales, las nuevas ofertas de Nvidia prometen acelerar enormemente el aprendizaje de la IA y su aplicación a numerosos campos como la robótica, la predicción meteorológica, el descubrimiento de fármacos y la automatización de almacenes. La GPU Nvidia Blackwell, los NIM, NEMO y la fundición de IA fueron algunas de las ofertas destacadas que se dieron a conocer.

El proceso de entrenamiento de la IA es mucho más intensivo desde el punto de vista informático que el uso de un modelo de IA, ya que deben procesarse millones de documentos de entrada. Esto puede llevar semanas, incluso meses, en los superordenadores más rápidos disponibles hoy en día para empresas como Microsoft. Nvidia lanzó anteriormente la plataforma de GPU Hopper en 2022 para manejar cargas computacionales tan grandes.

En la GTC 2024, Huang desveló Blackwell como la continuación de Hopper y está disponible como sustituto en placa para las instalaciones actuales de Hopper. La GPU Blackwell consta de dos troqueles de GPU de 104.000 millones de transistores en un proceso TSMC 4NP (probablemente N4P, error tipográfico en la presentación) para 20 FP4 petaflops con 192 GB de memoria HBM3e capaz de transferir 8 TB/s. En comparación, una gPU 4090 tiene una única GPU de 76.300 millones de transistores, proceso 5NM, hasta 1,32 petaflops FP8 de rendimiento tensorial con 24 GB de memoria GDDR6X. Si se duplica la cifra de FP8 del 4090 para ajustarla a 4 bits, son aproximadamente 20 petaflops Blackwell frente a los 3 petaflops del 4090.

Cuando 72 GPU Blackwell se alojan en un único DGX GB200 NVL72 junto con refrigeración líquida, CPUs NVLink mejoradasy otras mejoras de interconexión, el rendimiento con respecto a los armarios Hopper se multiplica por 22 para el entrenamiento de IA FP8 y por 45 para la inferencia de IA FP4. El consumo de energía para el entrenamiento de IA de Blackwell también se reduce aproximadamente 4 veces con respecto a Hopper.

Modelos de IA preempaquetados NIMS

Para aprovechar este salto en el rendimiento, Nvidia introdujo modelos de IA preempaquetados denominados NIMS (Nvidia Inference Microservice), que utilizan Kubernetes para ejecutarse en las GPU CUDA de Nvidia de forma local o en la nube. El acceso al NIMS autónomo se realiza a través de una API HUMANA simplificada. El objetivo detrás de esto es crear un futuro en el que los servicios de IA se creen pidiendo a una IA que cree una aplicación con ciertas características, entonces la IA mezcla y combina varios NIMS juntos sin requerir programación de bajo nivel. Por último, para ayudar en la formación de los NIMS, Nvidia presentó NeMO Microservices para personalizar, evaluar y custodiar el proceso de formación en documentos corporativos.

Nvidia BioNeMO y NIMS biológico

Huang anunció que Nvidia desarrollará NIMS entrenados en datos biológicos y médicos para proporcionar a los investigadores un acceso más fácil a la IA que puede mejorar todos los aspectos de la medicina, como encontrar candidatos a fármacos con mayor rapidez.

Thor ASIL-D y los vehículos eléctricos autónomos de BYD

Como dato significativo, Huang declaró que BYD será el primer fabricante de vehículos eléctricos del mundo en adoptar su nuevo ordenador Thor ASIL-D que utiliza un SoC de IA para procesar las entradas visuales y de conducción con el fin de proporcionar una gran seguridad en la conducción autónoma. Junto con el reciente anuncio de de SuperDrive by Plusesto sugiere que BYD será una de las primeras empresas automovilísticas en lanzar un Nivel 4 vehículo eléctrico autónomo.

Proyecto Groot de Nvidia robots humanoides

Huang demostró además sus avances en robótica exhibiendo las habilidades de sus robots, que primero se entrenan en el Omniverso como un gemelo digital, y después se les permite completar tareas en cuerpos robóticos de la vida real. Se mostraron tareas como hornear, girar palitos con los dedos, clasificar y ensamblar productos y sortear obstáculos. Para alcanzar este nivel de robótica, el Proyecto Nvidia Groot Se creó entrenándola primero con entradas de texto, vídeo y demostraciones, y refinándola después con observaciones reales de las tareas realizadas. Junto con el mismo ordenador Thor utilizado en los vehículos y Nvidia Tokkio AI modelo de lenguaje, los robots de demostración fueron capaces de observar acciones realizadas por humanos y, a continuación, replicarlas para preparar bebidas, tocar la batería y responder a peticiones habladas.

Nvidia Omniverse Cloud añade compatibilidad con Apple Vision Pro

De menor importancia, Huang declaró que Nvidia Omniverse Cloud https://www.nvidia.com/en-us/omniverse/ ahora transmite al Apple Vision Pro además de los auriculares Meta Quest y HTC Vive Pro, claramente para desarrolladores que utilicen GPU Nvidia en la nube, ya que ningún Macintosh dispone de una GPU Nvidia compatible.

Los lectores que quieran unirse a la revolución de la IA necesitarán una tarjeta gráfica Nvidia potente(como ésta de Amazon) para desarrollar habilidades y aplicaciones de IA.

NVIDIA lanza DGX SuperPOD con Blackwell para supercomputación de IA generativa a escala de billones de parámetros

Se amplía a decenas de miles de superchips Grace Blackwell utilizando la red más avanzada de NVIDIA, el software de IA NVIDIA Full-Stack y el almacenamiento Ofrece hasta 576 GPU Blackwell conectadas como una sola con NVIDIA NVLink Los expertos en sistemas de NVIDIA aceleran la implantación para una infraestructura de IA inmediata

18 de marzo de 2024

gTC-NVIDIA acaba de presentar su superordenador de IA de última generación, el NVIDIA DGX SuperPOD™ impulsado por los superchips NVIDIA GB200 Grace Blackwell, para el procesamiento de modelos de billones de parámetros con tiempo de actividad constante para cargas de trabajo de entrenamiento e inferencia de IA generativa a superescala.

El nuevo DGX SuperPOD, que incorpora una nueva arquitectura a escala de bastidor de alta eficiencia y refrigeración líquida, está construido con sistemas NVIDIA DGX™ GB200 y proporciona 11,5 exaflops de supercomputación de IA a precisión FP4 y 240 terabytes de memoria rápida, escalables a más con bastidores adicionales.

Cada sistema DGX GB200 cuenta con 36 NVIDIA GB200 Superchips - que incluyen 36 CPUs NVIDIA Grace y 72 GPUs NVIDIA Blackwell - conectados como un solo superordenador a través de NVIDIA NVLink® de quinta generación. Los GB200 Superchips proporcionan hasta 30 veces más rendimiento que la GPU NVIDIA H100 Tensor Core para grandes cargas de trabajo de inferencia de modelos lingüísticos.

"Los superordenadores DGX AI de NVIDIA son las fábricas de la revolución industrial de la IA", afirma Jensen Huang, fundador y CEO de NVIDIA. "El nuevo DGX SuperPOD combina los últimos avances en computación acelerada, redes y software de NVIDIA para que todas las empresas, industrias y países puedan perfeccionar y generar su propia IA"

El DGX SuperPOD impulsado por Grace Blackwell cuenta con ocho o más sistemas DGX GB200 y puede escalar hasta decenas de miles de GB200 Superchips conectados a través de NVIDIA Quantum InfiniBand. Para disponer de un espacio de memoria compartida masivo que alimente los modelos de IA de última generación, los clientes pueden implantar una configuración que conecte las 576 GPU Blackwell en ocho sistemas DGX GB200 conectados a través de NVLink.

Nueva arquitectura DGX SuperPOD a escala de bastidor para la era de la IA generativa

El nuevo DGX SuperPOD con sistemas DGX GB200 presenta un tejido de computación unificado. Además de NVIDIA NVLink de quinta generación, el tejido incluye las DPU NVIDIA BlueField®-3 y será compatible con la red InfiniBand NVIDIA Quantum-X800, anunciada hoy por separado. Esta arquitectura proporciona hasta 1.800 gigabytes por segundo de ancho de banda a cada GPU de la plataforma.

Además, la tecnología NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ de cuarta generación proporciona 14,4 teraflops de cálculo en red, lo que supone multiplicar por 4 la capacidad de la arquitectura DGX SuperPOD de última generación en comparación con la generación anterior.

Arquitectura llave en mano emparejada con software avanzado para un tiempo de actividad sin precedentes

El nuevo DGX SuperPOD es un superordenador de IA completo a escala de centro de datos que se integra con almacenamiento de alto rendimiento de socios certificados por NVIDIA para satisfacer las demandas de las cargas de trabajo de IA generativa. Cada uno se construye, cablea y prueba en fábrica para acelerar drásticamente la implantación en los centros de datos de los clientes.

El DGX SuperPOD impulsado por Grace Blackwell cuenta con funciones inteligentes de gestión predictiva para supervisar continuamente miles de puntos de datos en el hardware y el software con el fin de predecir e interceptar las fuentes de tiempo de inactividad e ineficiencia, ahorrando tiempo, energía y costes informáticos.

El software puede identificar áreas preocupantes y planificar el mantenimiento, ajustar con flexibilidad los recursos informáticos y guardar y reanudar automáticamente los trabajos para evitar tiempos de inactividad, incluso sin la presencia de administradores del sistema.

Si el software detecta que es necesario sustituir un componente, el clúster activará la capacidad de reserva para garantizar que el trabajo finalice a tiempo. Cualquier sustitución de hardware necesaria puede programarse para evitar tiempos de inactividad imprevistos.

Los sistemas NVIDIA DGX B200 avanzan en la supercomputación de IA para las industrias

NVIDIA también ha presentado el sistema NVIDIA DGX B200, una plataforma unificada de supercomputación de IA para el entrenamiento, el ajuste fino y la inferencia de modelos de IA.

DGX B200 es la sexta generación de diseños DGX refrigerados por aire y montados en bastidores tradicionales utilizados por industrias de todo el mundo. El nuevo sistema DGX B200 de arquitectura Blackwell incluye ocho GPU Blackwell de NVIDIA y dos procesadores Intel® Xeon® de 5ª generación. Los clientes también pueden construir DGX SuperPOD utilizando los sistemas DGX B200 para crear centros de excelencia de IA que pueden potenciar el trabajo de grandes equipos de desarrolladores que ejecutan muchos trabajos diferentes.

Los sistemas DGX B200 incluyen la función de precisión FP4 en la nueva arquitectura Blackwell, que proporciona hasta 144 petaflops de rendimiento de IA, una enorme memoria de GPU de 1,4 TB y 64 TB/s de ancho de banda de memoria. Esto proporciona una inferencia en tiempo real 15 veces más rápida para modelos de billones de parámetros que la generación anterior.

Los sistemas DGX B200 incluyen redes avanzadas con ocho NVIDIA ConnectX™-7 NIC y dos DPU BlueField-3. Estas proporcionan hasta 400 gigabits por segundo de ancho de banda por conexión - ofreciendo un rápido rendimiento de IA con las plataformas de red NVIDIA Quantum-2 InfiniBand y NVIDIA Spectrum™-X Ethernet.

Software y soporte experto para escalar la IA de producción

Todas las plataformas NVIDIA DGX incluyen el software NVIDIA AI Enterprise para el desarrollo y la implantación de nivel empresarial. Los clientes de DGX pueden acelerar su trabajo con los modelos básicos preentrenados de NVIDIA, los marcos, los kits de herramientas y los nuevos microservicios NVIDIA NIM incluidos en la plataforma de software.

Los expertos de NVIDIADGX y determinados partners de NVIDIA certificados para dar soporte a las plataformas DGX asisten a los clientes en cada paso de la implantación, para que puedan trasladar rápidamente la IA a la producción. Una vez que los sistemas están operativos, los expertos de DGX continúan apoyando a los clientes en la optimización de sus pipelines e infraestructura de IA.

Disponibilidad

Se espera que los sistemas DGX SuperPOD con DGX GB200 y DGX B200 estén disponibles a finales de este año a través de los partners de NVIDIA en todo el mundo.

Para obtener más información, vea la repetición de la keynote de la GTC o visite el stand de NVIDIA en la GTC, que se celebra en el Centro de Convenciones de San José hasta el 21 de marzo.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck