Samsung envía la memoria de IA más cara que Nvidia haya pedido nunca, ya que la HBM4 supera las especificaciones clave

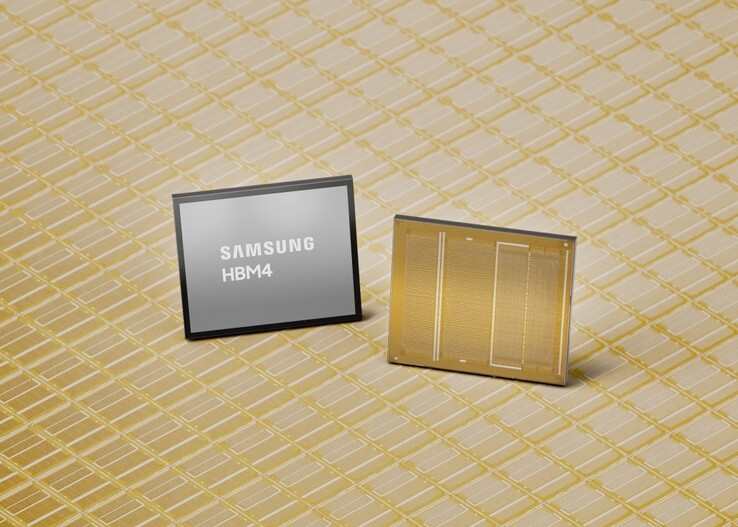

Samsung ha anunciado los primeros envíos comerciales de una memoria HBM4 de nueva generación para aplicaciones como las GPU de Nvidia y los respectivos centros de datos de IA.

Según los informes, Nvidia y otros clientes están pagando cerca de 500 dólares por unidad a Samsung, el doble de lo que pagaban por la anterior generación de memoria de gran ancho de banda HBM3E. Como consecuencia, las acciones de Samsung están en máximos históricos, y su dirección espera otro año de éxitos de taquilla aprovechando la escasez general de memoria escasez.

Especificaciones de la memoria HBM4 de Samsung

Mientras que los fabricantes de memorias cobran actualmente un ojo de la cara por cualquier unidad que produzcan, Samsung afirma que su nueva memoria HBM4 AI ha conseguido superar tanto la norma del Consejo Conjunto de Ingeniería de Dispositivos Electrónicos (JEDEC) como los requisitos de Nvidia.

La velocidad de funcionamiento de la HBM4 puede alcanzar la friolera de 13 Gbps, es decir, un 46% más que los requisitos del JEDEC, y su ancho de banda total de memoria es de hasta 3,3 TB/s por pila, superando con creces los 3 TB/s que piden clientes como Nvidia.

Samsung ha logrado este rendimiento vertiginoso aplicando de forma preventiva el proceso DRAM 1c de sexta generación de 10 nm con la matriz base fabricada a 4 nm, frente a la DRAM 1a de 14 nm que utilizó para la predecesora HBM3. Esto da a la generación de memoria HBM4 AI mucho margen para mejoras en el proceso y el rendimiento. Para gestionar todo el calor generado, Samsung diseñó el troquel base y la transmisión de datos con tecnologías de bajo consumo y bajo voltaje para conseguir una disipación del calor un 30% mejor y una eficiencia energética un 40% mayor en comparación con la generación de memoria HBM3 que Nvidia utiliza actualmente en sus tarjetas gráficas de IA de la serie Blackwell.

Por ahora, Samsung puede enviar a los clientes un máximo de 36 GB de capacidad de memoria HBM4 mediante un apilamiento de 12 capas, pero también puede elaborar un apilamiento de 16 capas para un total de 48 GB cuando Nvidia esté lista con el diseño de la GPU y el poder adquisitivo respectivos. Samsung promete una cantidad suficiente de los caros chips HBM4, afirmando que"continuará asegurando una capacidad de suministro estable para satisfacer la creciente demanda a medio y largo plazo, en particular de la IA y los centros de datos" cuando empiece a muestrear su memoria HBM4E de próxima generación en la segunda mitad de 2026.

Consiga el kit de memoria Crucial DDR5 de 64 GB para portátiles en Amazon

Fuente(s)

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck