CheckMag | El DLSS 3 de Nvidia fue el mayor perdedor del CES 2024

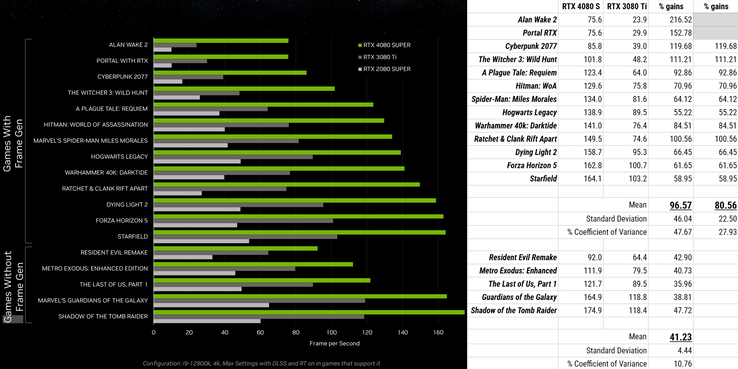

La RTX 4080 Super se presentó con la afirmación de un aumento de rendimiento 1,4 veces superior a la RTX 3080 Tiy cuenta con una letanía de especificaciones impresionantes para respaldar esas afirmaciones de rendimiento. Pero poco después, imágenes de juego de Alan Wake 2 mostraron framerates con la 4080 Super entrante sentados en aproximadamente el doble de los de la 3080 Ti saliente. Aunque esto pueda parecer un aumento impresionante, no lo es tanto si se piensa en la generación de fotogramas: cada fotograma renderizado por la 4080 Super se rellena con otro del DLSS 3, ¡lo que significa que las dos tarjetas gráficas alcanzan exactamente la misma velocidad de fotogramas no generada!

Y no se trata de un valor atípico que haga quedar mal a la 4080 Super -aunque la presencia de uno en la propia presentación de NVIDIA también sería bastante terrible-, ya que más material de marketing del equipo verde muestra el mismo resultado. Un examen de sus gráficos revela que la mejora media de rendimiento entre las dos tarjetas en juegos sin generación de fotogramas se sitúa en el 41%, en consonancia con las afirmaciones de NVIDIA, pero las ganancias en juegos con ella alcanzan una media del 97%, lo que confirma una vez más que, una vez que se sacan de la ecuación los fotogramas generados, la 4080 Super sólo iguala a la 3080 Ti.

Para colmo de males, esta cifra está sesgada al alza por los de peor rendimiento: si desea al menos una "tasa de imágenes por segundo nativa" de 40 FPS para mantener controlada la latencia de entrada, esa mejora media cae al 81% (y, para quienes puedan tildar esto de "cherrypicking", tal vez quieran tener en cuenta que AMD también sugiere 60 FPS nativos para su tecnología, y el dúo dinámico de Hardware Unboxed recomienda el doble de eso otra vez).

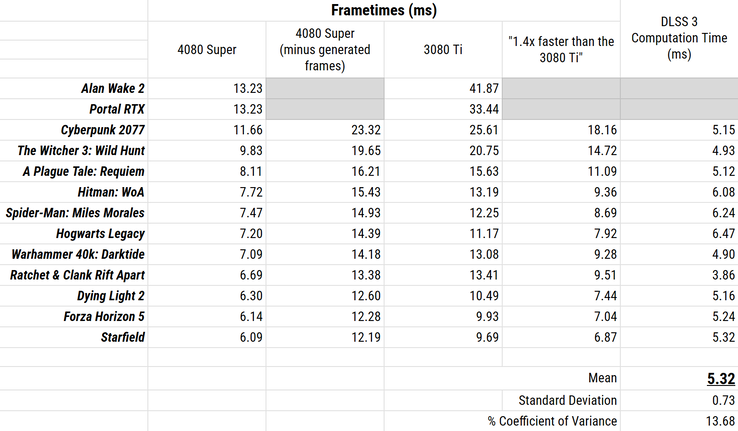

Lo que esto parece revelar es una verdad incómoda que NVIDIA ha dejado sin decir: que DLSS 3 es bastante caro computacionalmente. Si se observan los tiempos por fotograma en lugar de las frecuencias de fotogramas -es decir, (mili)segundos por fotograma en lugar de fotogramas por segundo-, esto queda más claro. La RTX 4080 Super tarda, por supuesto, menos tiempo en renderizar fotogramas que la RTX 3080 Ti, pero una vez contabilizados los fotogramas generados tarda más tiempo que si esperara un aumento uniforme del 41% respecto a la 3080 Ti. La diferencia en esos tiempos -cuánto más tarda la 4080 Super de lo que debería- es justamente lo que tarda DLSS 3 en hacer su magia.

Esa diferencia es de... 5.32 ms.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck

Cinco milisegundos puede no parecer mucho, pero se añade de manera bastante uniforme en todos los juegos que NVIDIA eligió para mostrar la RTX 4080 Super en su mejor momento. Es una sobrecarga, un arrastre parásito, un techo de rendimiento, y en juegos como Starfield constituye casi la mitad del tiempo que la 4080 Super emplea en renderizar el fotograma.

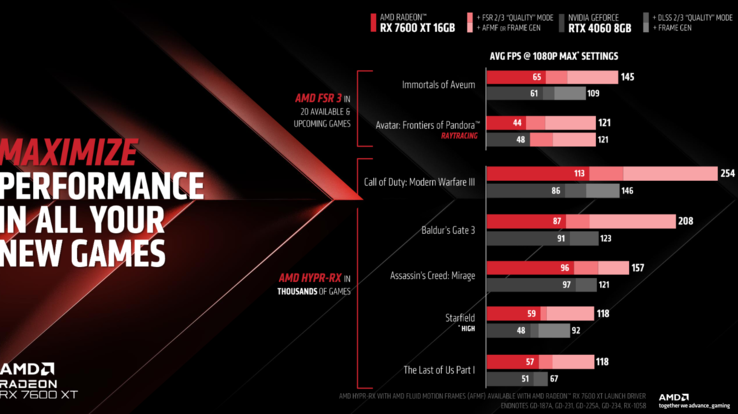

La generación de fotogramas parece haber llegado para quedarse, y parece que el tiempo de procesamiento empleado en ella va a ser el próximo campo de batalla. La presentación de AMD introdujo la RX 7600 XT para complementar la RX 7600 existente (que sigue siendo una gran compra en Amazon), y en esos gráficos pasó de superar a la RTX 4060 en un 31% renderizando de forma nativa en Call of Duty: Modern Warfare 3 a más del doble con FSR 3 y DLSS 3 activados, y haciendo lo mismo en Avatar: Frontiers of Pandora convirtió una ventaja del 9,1% para la tarjeta de NVIDIA en un empate. O FSR 3 ganaba terreno o DLSS 3 lo perdía, y eso apunta a que una solución es bastante más pesada que la otra.

Con las tecnologías FSR 3 y FMF del equipo rojo potencialmente con mucha menos sobrecarga que DLSS 3 -a pesar de que esta última se ejecuta en silicio dedicado de acelerador de flujo óptico- e Intel comenzando a hacer ruidos en el espacio framegen también, NVIDIA tiene algunas decisiones difíciles sin duda que se están haciendo en este momento. Los jugadores que intentan exprimir más potencia de una tarjeta gráfica de gama baja probablemente preferirán una mejora sustancial del rendimiento a una resolución más nítida, mientras que los que ya tienen velocidades de fotogramas elevadas no se ven tan afectados por los artefactos cuando cada fotograma individual generado sólo aparece en pantalla durante un breve período; una solución atractiva pero lenta no gana el análisis coste-beneficio en ninguna de las dos situaciones.

Entonces, ¿cuánta calidad de imagen vale realmente cinco milisegundos?

Fuente(s)

NVIDIA (Vía YouTube), AMD (Vía YouTube), TechSpot, Propio.