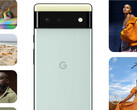

Google fue pionero en la fotografía computacional en los smartphones y ha ofrecido una calidad de imagen fija líder en el sector. La compañía ha seguido desarrollando este aspecto con su último Pixel 6 y Pixel 6 Pro y el desarrollo de lo que está llamando tecnología de cámara inclusiva. La compañía se sintió obligada a abordar lo que se ha identificado como sesgo racial inadvertido https://www.nytimes.com/2019/04/25/lens/sarah-lewis-racial-bias-photography.html en las cámaras de los teléfonos inteligentes, donde los tonos de piel de las personas de color pueden parecer lavados.

La compañía cree que sus últimas técnicas de fotografía computacional hacen que el Pixel 6 y el Pixel 6 Pro se destaquen del campo abarrotado de grandes cámaras de teléfonos inteligentes al poder capturar con mucha precisión y naturalidad los tonos de piel de las personas de color. Según Google, ha "diversificado radicalmente" las imágenes que entrenan su detector de rostros para detectar "rostros más diversos en una gama más amplia de condiciones de iluminación". Esto ha dado lugar a imágenes que corrigen la luz parásita que puede desteñir los tonos de piel más oscuros.

Como se puede ver en las dos imágenes de muestra del autor incrustadas debajo del artículo, Google parece haber cumplido su promesa. La imagen de la izquierda está tomada con la cámara frontal de 11,1 MP del Pixel 6, mientras que la de la derecha está tomada con la de 12 MP del iPhone 13 Pro Max de la cámara frontal. La diferencia entre las dos fotos es bastante marcada. La imagen del Pixel no solo carece de la luz parásita que hace que la imagen del iPhone parezca lavada, sino que también utiliza el aprendizaje automático en el chip Tensor para afinar la cara utilizando la medición del movimiento.

Teniendo en cuenta que Apple ha adoptado y promueve políticas de inclusión racial en muchos ámbitos diferentes, tanto interna como públicamente, será muy interesante ver cómo responde. ¿Podrá Apple añadir esta capacidad a la serie 13 del iPhone como una actualización de software, o los usuarios tendrán que esperar a la serie 14 del iPhone que se espera para octubre del próximo año?

Fuente(s)

Propio.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck