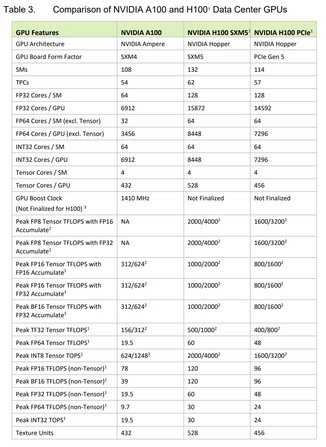

Las GPU Hopper H100 AI y HPC de Nvidia acaban de ser presentadas en la GTC junto con los superchips Grace. Como siempre, los modelos de GPU de cálculo son altamente escalables, y Nvidia ofrece varias soluciones multi-GPU para adaptarse a las diferentes necesidades de los centros de datos. Por otro lado, una sola GPU Tensor Core H100 viene con mejoras significativas respecto a la 2020 Ampere A100 especialmente en el departamento de operaciones de FP.

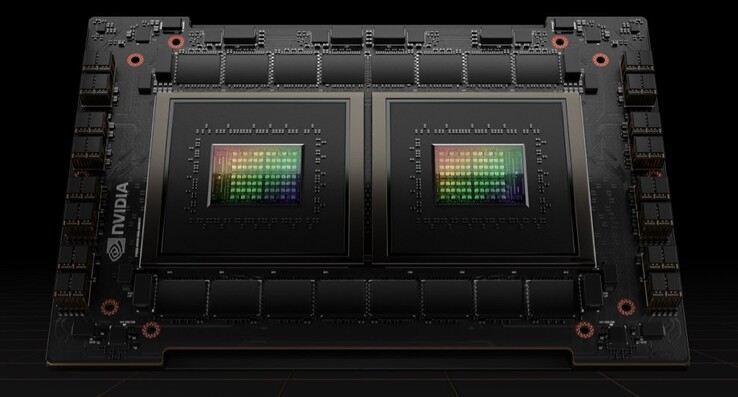

En primer lugar, la GPU H100 se fabrica en Nodos de 4 nm de TSMC y tiene un tamaño de matriz de 814 mm² (14 mm² menos que la A100). Este modelo es el primero de Nvidia que incorpora PCIe 5.0 y también hay un factor de forma SXM que es más rápido. La GPU en sí está compuesta por nada menos que 80.000 millones de transistores, lo que representa un aumento de casi el 50% con respecto a Ampere. También cuenta con 132 clusters de GPU con 16896 núcleos CUDA para el estándar SXM y 14592 núcleos CUDA para el estándar PCIe 5.0, lo que supone más que duplicar el recuento de la generación anterior

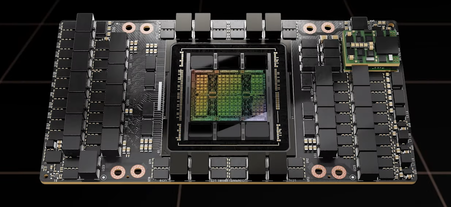

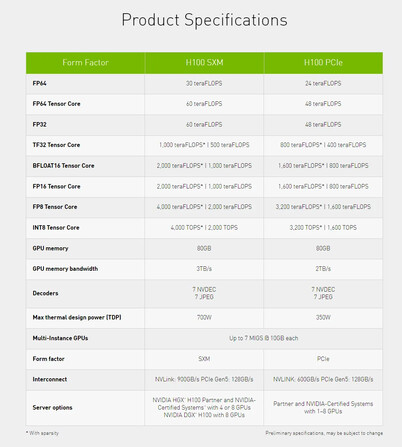

La caché L2 ha pasado de 40 MB a 50 MB, pero el bus de memoria sigue siendo el mismo, de 5.120 bits, y la capacidad de memoria se ha fijado en 80 GB HBM3 con un ancho de banda de 3 o 2 TB/s, dependiendo del factor de forma. La versión SXM cuenta con 528 núcleos Tensor y requiere 700 W, mientras que la versión PCIe sólo tiene 456 núcleos Tensor y está limitada a 350 W TGP. Nvidia afirma que 20 GPUs H100 pueden sostener el equivalente a todo el tráfico de Internet del mundo, pero la nueva arquitectura puede escalarse a cientos e incluso miles de clusters DGX que se utilizarán en futuros superordenadores

En cuanto al rendimiento de FP, la GPU H100 puede procesar 4 PFLOPS de FP8 (6 veces más que A100), 2 PFLOPS de FP16 (3 veces más que A100), 1 PFLOPS de TF32 (3 veces más que A100) y 60 TFLOPS de FP64/FP32 (3 veces más que A100). Se pueden obtener mejoras similares con los cálculos Tensor Core FP.

Nvidia también tiene previsto lanzar un Grace Hopper que combina una GPU H100 y una CPU Grace conectadas mediante un NVLink de 900 GB/s. Del mismo modo, también habrá un superchip Grace que combina dos CPU Grace que ofrecen 144 núcleos ARM, 1 TB/s LPDDR5x y 396 MB de caché en el chip. Este superchip Grace puede combinarse con hasta ocho GPU Hopper, pero estas configuraciones no estarán disponibles antes del tercer trimestre de 2023. Las GPU Hopper de Nvidia, sin embargo, empezarán a comercializarse en el tercer trimestre de 2022.

Compra la GPU de cálculo Nvidia Tesla v100 de 16 GB en Amazon

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck