En un movimiento un tanto inusual, Apple ha preanunciado nuevas funciones que llegarán a iOS 17 antes de su anuncio oficial. Las novedades más destacadas son Live Speech y Personal Voice Advanced Speech Accessibility, Assistive Access para ayudar a los usuarios con discapacidades cognitivas y un nuevo modo de detección en la lupa para ayudar a los usuarios con problemas de visión.

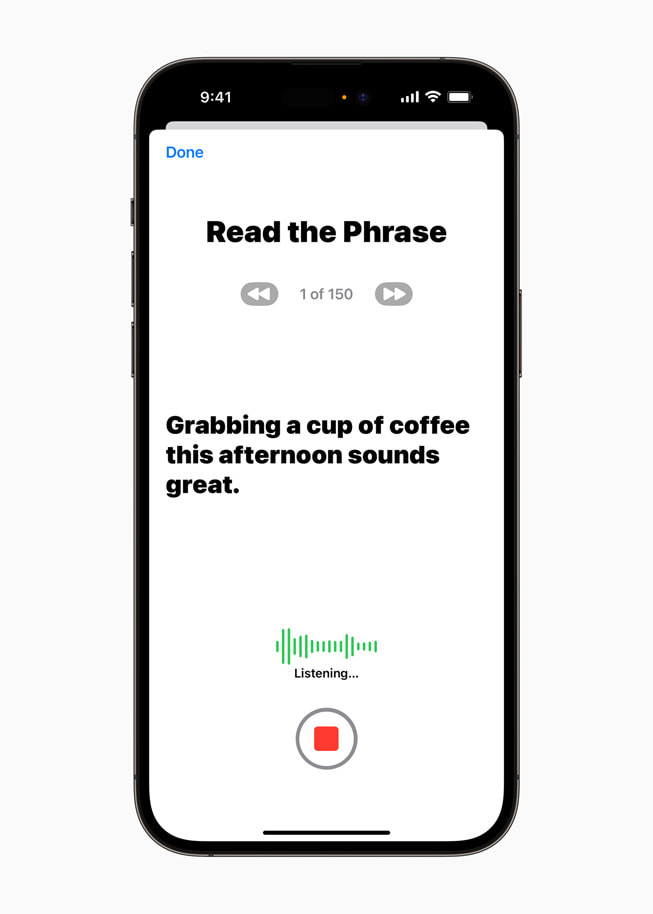

Tal vez la más futurista de ellas sea Voz Personal, que utiliza el aprendizaje automático (IA) en el dispositivo para permitir a los usuarios en riesgo de perder la capacidad de hablar (como alguien diagnosticado recientemente de ELA) crear una voz que suene como ellos. Los usuarios crean su Person Voice entrenando al modelo de IA para que recree su voz mediante la lectura de un conjunto aleatorio de mensajes de texto que tarda unos 15 minutos en completarse. Esto se integra con la nueva funcionalidad Live Speech, que permite a los usuarios escribir lo que quieren decir y que se lo digan en voz alta durante una llamada telefónica, una llamada FaceTime o una conversación en persona.

Assistive Access se ha diseñado para reducir las aplicaciones más populares del iPhone a sus funciones más esenciales y facilitar así su uso y la interacción con ellas. Apple ha trabajado con usuarios con discapacidades cognitivas y con quienes les apoyan para hacer más accesibles aplicaciones como Teléfono y FaceTime, convirtiéndolas en una única aplicación Llamadas, y simplificando también Mensajes, Cámara, Fotos y Música. El objetivo de estos cambios es reducir la carga cognitiva de los usuarios para que puedan hacer lo que quieran o disfrutar de su experiencia con el iPhone con menos complicaciones.

Apple también ha presentado un avance del Modo Detección en la aplicación Lupa -otra herramienta basada en IA-, que introduce la función Apuntar y Hablar para facilitar a los usuarios con discapacidad visual la interacción con objetos físicos de su casa o de su entorno que tengan varias etiquetas de texto. Por ejemplo, al utilizar un electrodoméstico como un horno microondas, Point and Speak combina las entradas de la cámara y el escáner LiDAR para leer el texto de cada botón a medida que los usuarios mueven los dedos por el teclado del horno. Point and Speak también funciona con la detección de personas, la detección de puertas y los descriptores de imágenes para ayudar a los usuarios a navegar más fácilmente por su entorno.

Aunque estos primeros avances de las nuevas funciones de accesibilidad que llegarán a iOS 17 son indicativos de que la WWDC 2023 estará repleta de anuncios, está claro que Apple también quiere demostrar que no se queda atrás a la hora de introducir funciones potenciadas por IA en sus productos.

Compra el último iPhone SE en Amazon desbloqueado y renovado por 399 dólares.

Fuente(s)

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck