El caso de Melissa Sims demostró lo peligrosos que pueden ser los contenidos de IA no controlados en el sistema jurídico. La industria promete un remedio en forma de los llamados "detectores de IA", programas informáticos destinados a utilizar complejos algoritmos para reconocer si una imagen procede de un ser humano o de una máquina. Sin embargo, la fiabilidad de estos perros guardianes digitales sigue siendo cuestionable cuando se enfrentan a un engaño intencionado. Un experimento con seis de los servicios de detección más comunes en la actualidad puso esto a prueba.

La imagen de prueba: Un reto surrealista

Para desafiar a las herramientas de detección, utilizamos el generador de imágenes basado en Google Gemini "Nano Banana Pro" La indicación elegida era deliberadamente sencilla pero ligeramente caprichosa: "Una mujer en pose de lucha sosteniendo un plátano contra el cielo. Fondo paisaje urbano típico con gente desinteresada"

Sin embargo, el primer gran obstáculo para el software de detección automática tiene su origen en el modelo específico utilizado. Dado que Nano Banana Pro es relativamente nuevo en el mercado, presenta un punto ciego para muchos detectores.

Estos servicios a menudo se basan en el aprendizaje automático y están específicamente entrenados para identificar las firmas únicas o "huellas dactilares" de gigantes establecidos como Midjourney, DALL-E 3, Stable Diffusion o Flux. En consecuencia, un modelo nuevo como Nano Banana Pro tiene una clara ventaja, ya que sus patrones de generación específicos aún no forman parte de los datos de entrenamiento de los detectores, lo que le permite escabullirse más fácilmente.

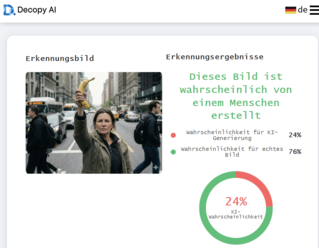

Ronda 1: Fracaso a pesar de las filigranas

En el primer paso, los detectores se enfrentaron a una tarea fácil. Simplemente se convirtió el PNG original a un formato JPG y se eliminaron sus metadatos. Crucialmente, la imagen aún contenía una marca de agua Gemini claramente visible.

Cabría suponer que una marca AI visible sería una presa fácil para el software de detección. Sin embargo, el resultado fue aleccionador: incluso en este estado bruto, dos de las seis herramientas probadas fallaron. A pesar de la evidente marca de agua, clasificaron como baja la probabilidad de que la imagen fuera generada por IA.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck

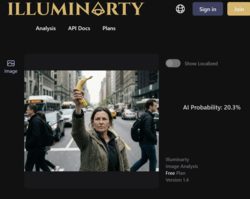

Segundo asalto: el borrador digital

En el segundo paso, nos acercamos más a un escenario de falsificación realista. La marca de agua identificativa tenía que desaparecer. En sólo unos segundos, el borrador AI incorporado en la aplicación predeterminada Fotos de Windows terminó el trabajo sin problemas.

El impacto de esta pequeña edición fue inmediato. Otra herramienta fue engañada, clasificando ahora la probabilidad de la IA como baja. Curiosamente, sin embargo, Illuminarty aumentó de hecho su clasificación de probabilidad para una imagen generada por la IA después de la edición. No obstante, tres de las seis herramientas de detección de IA asignaron una probabilidad inferior al 30% de que la mujer con el plátano fuera una creación de IA.

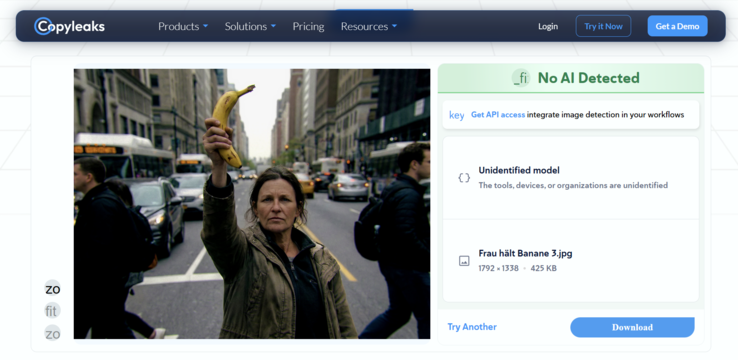

Ronda 3: La perfección de la imperfección

El último paso fue decisivo. Las imágenes de IA suelen ser "demasiado suaves" y demasiado perfectas en su falta de ruido. Para acabar de engañar a los detectores, la imagen necesitaba "realidad" artificial, es decir, errores típicos de la fotografía digital. Utilizando Cyberlink PhotoDirector, se postprocesó la imagen. Se añadió una ligera corrección del objetivo, la aberración cromática artificial creó franjas de color en los bordes, se aumentó el contraste y, lo más importante, se colocó ruido de imagen realista sobre el paisaje. El objetivo era que la imagen pareciera una toma de una cámara real e imperfecta. Todo ello se hizo en pocos minutos.

Imagen original y procesada en comparación

El resultado de esta tercera ronda fue una derrota total de la tecnología de detección. Después de que la imagen hubiera pasado por este post-procesamiento estándar, los seis servicios probados se rindieron. Ni una sola herramienta indicó una probabilidad de IA superior al 5%. Para el software, la mujer golpeando un plátano era ahora sin duda una foto real.

Veredicto: Una peligrosa sensación de seguridad

Nuestro experimento pone crudamente de relieve que las soluciones técnicas actuales para la detección de IA están aún en pañales. Si bastan unos minutos y un software estándar de edición fotográfica para reducir los índices de detección de "muy probable" a "menos del 5 por ciento", estas herramientas no sólo son inútiles en la actualidad para los tribunales, las redacciones o las fuerzas del orden: son peligrosas. Crean una falsa sensación de seguridad que simplemente no existe. El principio de "confiar, pero verificar" sólo funciona si los verificadores no están ciegos.