Mientras Nvidia disfruta actualmente de beneficios extraordinarios a medida que se sube a la ola de la IA con la creciente demanda de GPU de cálculo, el mercado podría descentralizarse a medida que más empresas intervengan para ofrecer procesadores de IA alternativos viables. Hemos visto esfuerzos de varias empresas en este sentido, entre ellas AMD, d-Matrix, OpenAI y Samsung. Parece que bastantes ingenieros que ayudaron a diseñar la unidad de procesamiento tensorial (TPU) de Google participan ahora en proyectos independientes de IA que prometen superar a las soluciones de Nvidia. Samsung, por ejemplo, anunció recientemente que su nuevo laboratorio de computación AGI, que abrirá sus puertas en Silicon Valley, está dirigido por el antiguo desarrollador de la TPU de Google, el Dr. Woo Dong-hyuk. Otro ingeniero clave que colaboró en el desarrollo de la TPU de Google es Jonathan Ross, que ahora es consejero delegado de una nueva empresa llamada Groq. Aprovechando la experiencia acumulada en Google, Ross aporta innovación al mercado de los aceleradores de IA con la primera Unidad de Procesamiento del Lenguaje (LPU) del mundo.

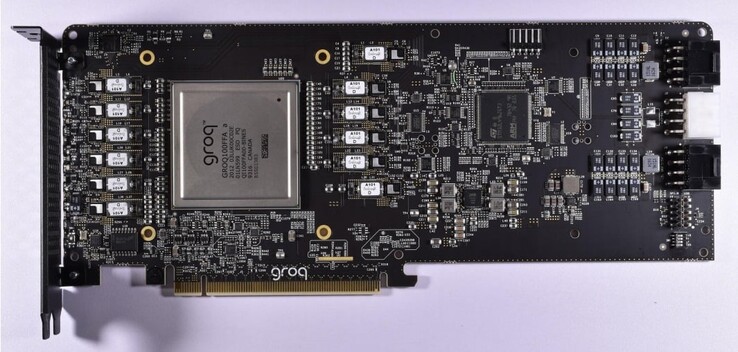

La LPU de Groq está diseñada específicamente para procesar grandes modelos lingüísticos (LLMs) y presenta claras ventajas sobre las GPU de propósito general o las NPUs. Groq desarrolló inicialmente el procesador de flujo tensorial (TSP), que más tarde fue rebautizado como unidad de procesamiento del lenguaje para reflejar su mayor destreza en tareas de IA generativa basadas en la inferencia. Al estar centrada únicamente en los LLM, la LPU es mucho más ágil que una GPGPU y permite simplificar el hardware de programación con una latencia más baja, un rendimiento sostenido y una mayor eficiencia.

En consecuencia, la LPU reduce el tiempo de cálculo por palabra y las secuencias de texto pueden generarse mucho más rápido. Otra mejora clave es que la LPU elimina la necesidad de memoria costosa (HBM), ya que sólo utiliza 230 MB de SRAM por chip con un ancho de banda de 80 TB/s, lo que la hace considerablemente más rápida que las soluciones GPGPU tradicionales. La arquitectura de Groq también admite la escalabilidad, ya que se pueden interconectar varias LPU para proporcionar una mayor potencia de procesamiento a los LLM más complejos.

Para demostrar lo mucho más rápido que es el motor de inferencia LPU en comparación con las GPU, Groq ofrece una comparación en vídeo de su propio chatbot que puede alternar entre los LLM Llama 2 / Mixtral frente a los de OpenAI Chat-GPT. Groq afirma que el LLM genera el texto en una fracción de segundo y que el otro 3 ⁄ 4 del tiempo se dedica a buscar información relevante.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck