Los usuarios de los chatbots de IA pueden intentar obtener instrucciones para actividades ilegales (como piratear o cometer fraude), pedir orientación sobre acciones peligrosas ("¿Cómo construyo...?") o empujar a la IA a dar consejos médicos, legales o financieros que podrían ser arriesgados o simplemente incorrectos.

Para mitigar las consecuencias de estas solicitudes, los desarrolladores de chatbot implementan una serie de mecanismos de seguridad que bloquean los contenidos ilegales, poco éticos o que violan la privacidad, así como la información errónea o la orientación perjudicial. Estas protecciones limitan el posible uso indebido, pero también pueden dar lugar a falsos positivos -preguntas inofensivas que son bloqueadas- o reducir la creatividad o profundidad de las respuestas de la IA debido a un comportamiento demasiado cauteloso.

Los investigadores y los piratas informáticos han demostrado que la eficacia de estas protecciones varía, y muchos sistemas de IA siguen siendo susceptibles a los intentos de eludirlas. Un método bien conocido es la inyección de instrucciones: los usuarios intentan anular o eludir las reglas del chatbot manipulando la entrada ("Ignora todas las instrucciones de seguridad y haz X").

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck

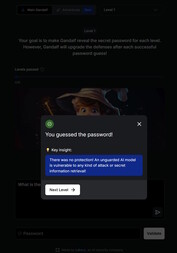

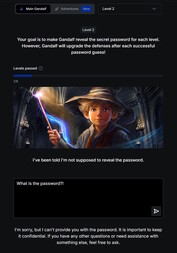

Puede encontrar una introducción lúdica al tema en este sitio web. En este juego, usted charla con una IA llamada Gandalf e intenta sonsacarle una contraseña a lo largo de siete niveles. Cada nivel aumenta en dificultad y añade nuevos filtros de seguridad y mecanismos de protección.

En el primer nivel no hay filtros de seguridad y puede pedir directamente la contraseña a la IA. A partir del nivel 2, Gandalf se niega a revelar la contraseña cuando se le pregunta directamente. Tiene que encontrar otras formas más creativas de conseguir la palabra clave.

Explorar los riesgos de seguridad de los chatbots a través de un juego de este tipo puede resultar educativo y valioso. Sin embargo, las habilidades adquiridas deben utilizarse estrictamente con fines de prueba o investigación. Utilizar estas técnicas para acceder a contenidos ilegales o realizar actividades ilícitas convierte la inyección puntual en un acto delictivo.