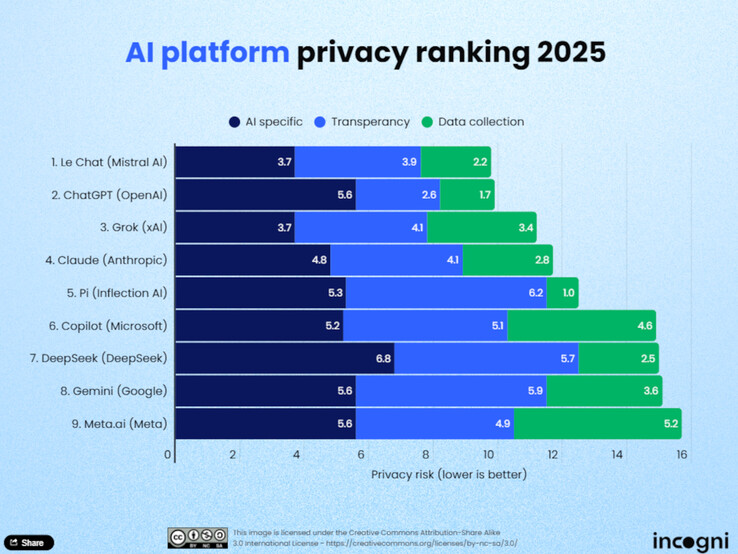

El uso de la inteligencia artificial (IA) en la vida cotidiana es cada vez mayor, y con él la importancia de la protección de datos. Los analistas de protección de datos de Incogni han evaluado recientemente nueve grandes modelos de lenguaje (LLM) para determinar qué plataformas respetan más la privacidad de los usuarios. El estudio evalúa los modelos de IA en función de once criterios divididos en tres categorías principales: recopilación de datos para el entrenamiento, transparencia y uso e intercambio de datos.

Mejores clasificaciones

Le Chat de Mistral AI encabeza la clasificación. Según Incogni, el modelo recopila comparativamente pocos datos de los usuarios y ofrece un enfoque muy eficiente de los datos, tanto durante la fase de formación como en el funcionamiento en directo. Le sigue de cerca ChatGPT de OpenAI, que gana puntos sobre todo por su transparencia. Los usuarios pueden especificar en su cuenta si sus chats pueden utilizarse para seguir desarrollando el modelo, y si se desactiva el historial, se impide su almacenamiento. Grok de xAI ocupa el tercer lugar, impresionando también por sus prácticas transparentes de protección de datos.

Los últimos de la clasificación

Al final de la clasificación se encuentran Meta AI, Gemini de Google y Copilot de Microsoft. Según Incogni, estas plataformas recopilan gran cantidad de datos sin ofrecer a los usuarios opciones claras de exclusión. DeepSeek, un modelo chino, también obtiene malos resultados. Estos proveedores no ofrecen opciones claras para excluir los datos de los usuarios del entrenamiento.

Metodología

Los analistas de Incogni evaluaron las plataformas basándose en once criterios divididos en tres categorías: recopilación de datos para la formación, transparencia y uso e intercambio de datos. La categoría "uso e intercambio de datos" representó el 50% de la calificación global, mientras que "transparencia" supuso el 30% y "datos para la formación" el 20%. Sólo cuatro de las nueve herramientas probadas permiten a los usuarios excluir activamente sus datos de la formación.

Conclusión

El estudio muestra que la protección de datos aún no es una norma en todo el mundo de la IA. Por lo tanto, los usuarios deben familiarizarse activamente con las políticas de privacidad de los proveedores, especialmente cuando se trata de contenido sensible, información confidencial de clientes o datos personales. Quienes valoren la protección de datos encontrarán opciones razonables en Le Chat, ChatGPT o Grok. Sin embargo, los LLM verdaderamente eficaces en materia de datos seguirán siendo la excepción en 2025

Fuente(s)

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck